‧

阅读时间:5 分钟

我们如何丰富客户联系和组织数据

Max Zheng

‧ 5 分钟阅读

分享本文

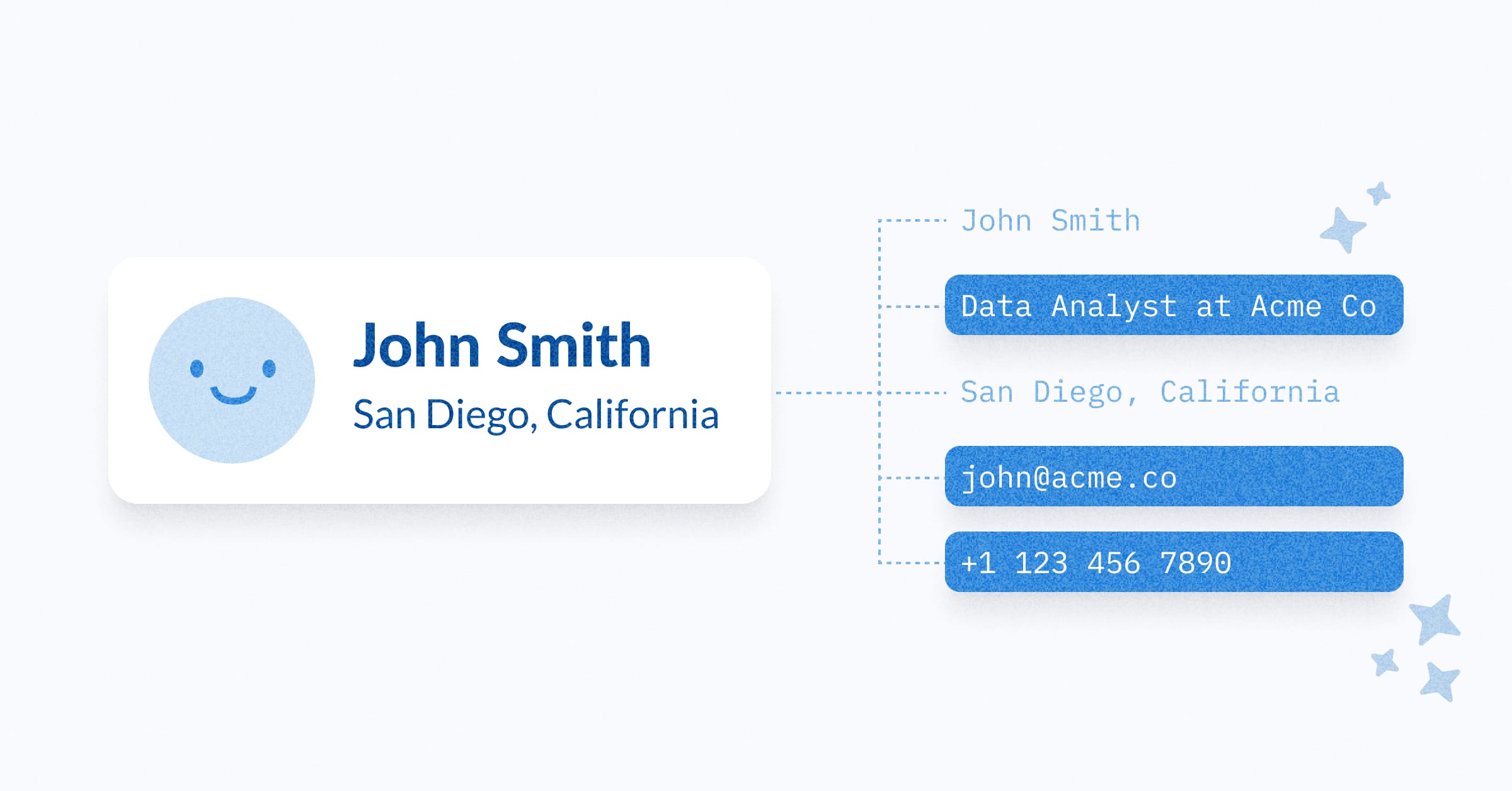

我们希望为收集到的数据获得更多背景信息,因此我们考察了数据增强服务。这些公司可以为您的数据提供更多细节。例如,给定一个域名,第三方增强服务可以为您提供该域名的关联公司名称、规模、行业等信息。

数据增强是成长型公司,特别是大型公司的典型做法。但在您开始考察增强服务之前,您应该清楚需要解决的已知问题(或要实现的目标),以便增强服务能够提供帮助。对于 Metabase 而言,我们出于两个原因希望增强我们的客户联系信息:

- 保持与客户的联系。 增强服务可以提醒我们联系人工作变动的信息,这可能会影响我们的关系。例如,如果一位联系人转到公司内部或外部的另一个职位,我们可能想联系他们表示祝贺,并确保与接替他们职位的人保持联系,以免重要的产品通讯丢失。

- 更好地了解组织的规模和行业, 这有助于我们定制营销和产品策略,确保我们构建 Metabase 以解决这些细分市场所面临的问题。

服务提供商评估

数据增强的服务提供商出奇地多,每个都有其优缺点。虽然我们考虑过各种 LinkedIn 数据转储提供商,但我们还是决定不使用它们,因为我们不应该在数据仓库中存储这类数据。我们也没有评估 Clearbit,因为它已不再是独立的服务。

要点:Apollo.io 在我们的用例中提供了最佳的覆盖范围、定价和功能。

| 标准 / 提供商 | LinkedIn Sales Navigator | Crunchbase | Lusha | Apollo | CommonRoom |

|---|---|---|---|---|---|

| 工作历史 / LinkedIn 个人资料 | 最佳可用,但仅限 UI 访问;API 访问受限 | 不可用 | 不可用 | 好 / 最近更新 | 大部分很好,但部分近期工作变动缺失 |

| 公司信息,如行业规模、行业等 | 好。搜索仅限 UI;API 访问受限 | 好,但针对 100 位近期联系人,覆盖率约 70%(高/中)到 80%(低置信度) | 一般。针对 100 位近期联系人,覆盖率约 26% | 使用域名匹配针对 100 位近期联系人,覆盖率高,达到 80% | 似乎主要对公司规模可用,但行业信息参差不齐,且针对近期 100 位联系人的覆盖率约 60% |

| 人口统计信息,如职位等 | 极好 / LinkedIn 个人资料上的所有信息。搜索仅限 UI;API 访问受限 | 仅限于选择关键人物,如高管 | 一般。针对 100 位近期联系人,覆盖率约 26% | 好,针对 100 位近期联系人的姓名覆盖率 60%,职位/历史记录覆盖率 50% | 是,但:1. 针对 100 位近期联系人,组织覆盖率约 60%,职位覆盖率约 30% |

| 导出到数据仓库 | 仅与 CRM 集成,例如Salesforce 或 HubSpot,功能有限(因 CRM 而异) | 企业版支持数据集下载。API 可进行精确域名/名称和模糊搜索。每分钟 200 次调用,限制 1000 次 | 通过 UI 或 API 进行 CSV 上传/下载 | API 或 CSV(UI)联系人增强速度慢,每秒 0.5 次调用 — 即每 10k 条记录 1.4 小时。API 提供批量下载,一次 10 条 | 仅企业版支持定期/自定义导出,否则通过 UI 手动。UI 上可见的任何字段均可通过 UI 导出 |

| 成本 | 核心:每人/年 960 美元。带 CRM 集成的进阶版:每人/年 1600 美元 | API:每年 10k 美元,享受 30% 的即时购买折扣。超过 300 万家公司的 CSV 导出:50k 美元,享受 50% 的即时购买折扣 | 约 20k 至 25k 美元/年,针对 100k 联系人 | 每月 400 美元,API 增强 10k 次。每条记录 4 美分。每月 3k 美元,增强 100k 次。每条记录 3 美分。更多计划选项 | 许多计划,从免费到企业版,根据联系人和功能定价:1. 免费,最多 500 位联系人/50 个组织 2. 入门版,每月 625 美元,最多 35k 联系人。 3. 专业版,每月 1250 美元,最多 100k 联系人。 4. 企业版,定制定价,支持导出到数据仓库功能。每年 50k 美元以上 |

持续增强

选定服务提供商后,我们使用 dlt 和 Apollo.io 的 API 每小时增强新联系人,并根据优先级排序 — 优先处理新联系人,然后更新现有联系人,依此类推。

这是 Python 代码片段,它

- 从我们数据仓库中的优先级列表联系人中获取电子邮件列表

- 调用 Apollo 的 API 来增强这些联系人。

- 然后将增强后的信息保存回我们数据仓库的另一个表中。

def enrich_contact(self, postgres_connect_string, to_schema):

pipeline = dlt.pipeline(pipeline_name='enrich_contact', destination='postgres', dataset_name=to_schema,

credentials=postgres_connect_string)

@dlt.resource(write_disposition='merge', primary_key='email')

def enriched_contact():

with pipeline.sql_client() as psql:

with psql.execute_query("select email from prioritized_contact") as cursor:

emails = cursor.fetchall()

for (email,) in emails:

enriched = self.people_match(email) # Call Apollo's "people/match" API

yield enriched['person']

print(pipeline.run(enriched_contact))

为自助分析建模

我们将增强后的数据,如组织规模和行业,添加到我们的客户和联系人模型中。对于组织规模,我们将数据分为了几个类别,以简化我们团队的分析。

, case

when estimated_employees <= 50 then 'Micro'

when estimated_employees <= 200 then 'Small'

when estimated_employees <= 1000 then 'Medium'

when estimated_employees <= 10000 then 'Enterprise'

when estimated_employees > 10000 then 'Mega Enterprise'

end as organization_size

在我们的联系人模型中,我们还添加了 left_company_at 字段,以指示联系人何时离开了客户组织。此字段可方便地查找我们应该联系哪些组织,以便他们及时了解重要的产品通讯。

关于数据增强的最终想法

增强我们的数据已证明非常有价值。从增强数据中获得的一个有趣见解是,我们的客户来自各种规模的组织,从小型到超大型。我们的团队已经利用这些数据更好地了解我们的客户并监控工作变动。

我们现在正在讨论如何将增强用于其他目的,例如创建理想客户画像,以最大限度地发挥营销效果。

但增强并非免费,因此我们将继续评估我们获得的价值与成本的关系,并据此进行迭代。我们希望这篇博文能帮助您选择适合您需求的数据增强服务。